文/VR陀螺

太平洋时间6月10-12日,AWE(世界增强现实博览会)在洛杉矶长滩会展中心举办,据了解今年展会吸引了超过250家展商,450名演讲者参与。作为XR领域最大的专业展会,VR陀螺今年作为媒体合作伙伴到现场参与了本次盛会。

今年Google、高通、三星、Niantic、Snap、Sony、PICO、XREAL、亿境虚拟等均参与了本次展会,抛开这些巨头以及具备一定规模的企业,整体来看初创团队居多,而展会覆盖的范围也非常广,涵盖VR头显、AI眼镜、AR眼镜、芯片、屏幕、光学、内容解决方案、VR游戏等。

AWE参展商盘点

具体参展商如下:*以下排名不分先后,展商信息或有遗漏之处,欢迎补充

Snap CEO兼联合创始人Evan Spiegel出席本次AWE大会并发表演讲,从他公布的数据中可知:Snapchat现已覆盖全球超过9亿人,扩展了地图服务等新业务,其AR滤镜每天被使用超过80亿次,是世界上最大的AR平台之一。此外,Snapchat的AR技术已应用于多个领域,如体育场、购物和娱乐的AR镜子等。

至今为止Snap的生态已经非常完善,包括AR眼镜终端Spectacles(开发者版)、开发套件Lens Studio、手机端的社交平台等。

图源:VR陀螺

在AR终端上,据了解其已投入超过11年和30亿美元,目前推出了第五代独立、轻便、沉浸式的AR眼镜Spectacles,无需头戴设备、控制器或手机即可使用,其眼镜搭载了专为AR打造的操作系统。

VR陀螺在现场体验了该终端,眼镜整体体积相比普通眼镜偏大,整体重量约226g,不支持镜腿外扩所以对于头大的用户可能会出现夹头的情况。

图源:VR陀螺

光学方面使用衍射光波导,46度FOV,PPD 37,接近10英尺外100英寸屏幕的视觉效果。眼镜内置双芯片,搭载4个摄像头,可以进行6DoF 空间定位、手势识别等。

VR陀螺在现场体验了多个游戏,眼镜下方两个空间定位摄像头设计了向下倾斜,所以即便手在胸前偏下的位置依旧可以捕捉到,空间定位效果有一定抖动,但整体很稳定。手势识别可以用于打开菜单、拖动、选择等。当手掌张开时,菜单按键浮现于手掌,触摸点击打开,其后在画面中将出现光标,食指与拇指捏合即可移动光标,实现对话框的拖动、点击等。值得一提的是,眼镜引入了电致变色,可以支持镜片明暗调整(两段调节)。

从内容生态来看,目前Snap已经聚集了全球40多万开发者创建的超过400万个AR滤镜,同时,其目前也在向更为深度的AR游戏方向拓展。现场展示了多款游戏,包括射箭、打鼓、塔防射击等休闲体验,全都基于手势交互,现场反馈非常不错。

同时,Snap还面向开发者推出了Lens Studio 5.0版,支持模块化编辑,并即时在AR眼镜上呈现,现在该平台主要面向Snap眼镜的开放,同时用户还可以生成自己的 AI 效果、添加 Bitmoji 以及浏览流行模板来创建自定义滤镜。Even表示该工具即将支持Web端。

最后Even提到,2026年Snap将推出Spectacles的迭代版,正式面向消费市场销售。

高通XR高级副总裁兼总经理Ziad Asghar在大会上谈到如何通过更优的硬件、连接和AI来扩展空间计算。并强调了高通致力于在XR普及率不断增长的同时,支持开发者和企业的承诺。

其中一项引人注目的信息是,高通发布其最新的AI眼镜专用芯片AR1+ Gen1,支持10亿参数端侧小语言模型。据了解,该方案相比AR1有具备更小的打包体积,在核心功能使用场景中功耗可节省7%,拍照效果更好,以及更强的性能,并且支持眼镜端侧小语言模型。高通还表示骁龙AR1+ Gen 1芯片等技术将实现“更纤薄的外形,同时不影响AI模型的运行能力”。由此可见,在不久的将来,这款芯片将出现在更纤薄的独立 AI 智能眼镜中。

图源:VR陀螺

骁龙AR1+ Gen1能将AI眼镜提升到一个新的水平——将AI直接引入设备,提升图像质量,并在需要时实现无缝连接。高通在现场展示了一段与AI的语音对话,可以看到对话存在一定的延迟,但该小语言模型足够处理日常的AI提问需求。

高通展台上展示了多款VR、AR、AI设备,包括尚未上市的三星MR头显等。

图源:VR陀螺

同时,雷鸟X3 Pro也出现在高通的多个应用展区,作为雷鸟不久前发布的新品,其使用全彩Micro-LED+衍射光波导方案,三色合色全彩方案,配合 0.1cc 超小聚合 Cube 棱镜,实现 1670 万色全彩显示输出,峰值入眼亮度 6000nits,平均入眼亮度 3500nits;芯片方面使用高通AR1,带来强大的性能体验。雷鸟X3 Pro在保证了极限性能和功能的同事,将产品重量压缩至 76g,有效平衡了性能与佩戴舒适性。

图源:VR陀螺

在高通展台上,还结合AR眼镜产品展示了KiWear的3DoF+手势交互戒指。

该戒指支持3DoF以及部分手势交互,可连接平板、AR眼镜使用,未来甚至能连接更多IoT产品。VR陀螺在现场体验了该戒指,可以说是目前交互戒指中整体体验最好的一款产品,其不仅具备基础的健康检测功能,如心率检测等,同时还可以用作电子产品的操控设备,下载App连接蓝牙即可使用。

从视频中可以看到,通过转动戒指以及画圈、画勾/叉、捏合等多个手势可实现切换APP、调节音量、接听/挂断语音、暂停/播放、上一曲、下一曲等多个交互,且戒指交互的响应速度非常快,几乎感受不到延时,而且戒指佩戴的朝向,以及戴上戒指进行其他操作(如敲击键盘、拿取物品等)均不会出现误触或影响体验。

此外,VR陀螺还在现场体验了该戒指与雷鸟X3 Pro眼镜连接使用,搭配眼镜的状态下,几乎所有眼镜上的交互都可以在戒指上完成,调节音量、拍照、录像、切换App、唤起AI助手等。

VR陀螺认为,虽然如今的AI、AR眼镜的交互已经足够便捷,触摸板+一个物理按键几乎能解决大部分的交互,但是相对于抬手按键&触控交互,戒指一方面更为省力便捷,同时动作幅度更小更隐蔽,同时其还兼具健康监测功能,对于AR眼镜来说不失为一种极具潜力的交互方式。

据了解,KIWEAR在交互领域已有超过10年经验,众多VR头显的VR手柄均有该公司参与,此外,索尼XYZ头显套装中的戒指和画笔均为该团队设计。该团队从最初的视觉算法手势交互,到如今基于IMU、电磁等传感器的戒指、腕带交互,对人机交互有非常深厚的理解和技术积累。此外,据了解团队后续还将发布6DoF腕带、戒指等产品。

谷歌的XR产品管理总监Juston Payne和XR生态系统战略和技术高级总监Hugo Swart登台演示了Android XR,概述了谷歌的最新平台将如何带动一系列专为全天候佩戴和集成体验而设计的XR头显和眼镜。Android XR由谷歌与三星、高通合作开发,支持多模式输入和可扩展开发。

此前谷歌I/O 2025开发者大会上,一度表示其有计划将Gemini AI引入Android XR。谷歌与三星合作开发的XR头显Project Moohan将于今年晚些时候上市的消息也在AWE上进一步得到证实。

Niantic Spatial首席技术官Brian McClendon向观众介绍了大型地理空间模型(LGM)——旨在帮助AI解读物理世界并与之互动的强大工具。他概述了地理空间智能如何赋能从AR眼镜到自主机器人等各种设备,使其能够以更丰富的情境信息和更精准的精度进行导航。

大会期间,Snap还与Niantic Spatial签署了一项为期多年的战略合作协议。今年晚些时候,Snap将为旗下的Lens Studio、Snapchat和Spectacles AR眼镜引入Niantic Spatial的扫描技术以及视觉定位系统(VPS),这将有利于简化以及扩展Snap的室外AR内容体验。此外,公告中指出,Snap将为Niantic Spatial提供额外资金支持,具体金额不详。

得益于双方合作,后续Snap开发者将能获得以下技术支持:精准定位的Niantic Spatial的视觉定位系统支持;Snap的用户以及开发人员可以扫描真实地图并上传;利用AI Agent始终在线的定位、精准导航和对周围环境的情境感知能力,进一步感知和推理世界。(注:空间智能是Niantic Spatial提出的一个概念,它指的是将AI引入3D地图的一种全新体验)

XREAL现场展示了XREAL One Pro和XREAL Eye,这两款产品都将于今年7月公开发售,XREAL One Pro可在6月底之前以599 美元的早鸟价预订。专为AR设计的移动电源XREAL Neo具有视频直通功能、10000mAh电池和20W快速设备充电功能,将于今年夏天晚些时候上市。

而在演讲上重点提到的Project Aura是一款由XREAL开发的搭载Android XR系统的眼镜设备,该产品曾在谷歌I/O大会期间短暂亮相,但是具体规格不详。而在本次大会上,则进一步公开了更多关于Project Aura的参数信息。

计算单元外置与Orion类似,Project Aura也将会采用算力外置的策略,产品将会配备一个类似于冰球的计算单元,眼镜与计算单元采用线缆连接。设备配备了两套芯片,眼镜端将搭载X1s,它可视为此前曾出现在XREAL One中的3DoF芯片 X1的升级版,而计算单元则会搭载算力更强的处理芯片。眼镜配备前置传感器,支持原生6DOF空间追踪、手势交互与环境感知。显示方面配备“平面棱镜”镜片,可以提供70°的大FoV。

索尼在AWE展示了其解决方案并发布XYN品牌下集成解决方案套件的全新增强功能。

索尼与西门子共同开发的最新XYN头显与三星Project Moohan一样,搭载高端骁龙XR2+ Gen 2芯片组,专为空间内容创作而优化,旨在支持更广泛的创作者。其沉浸式工程解决方案将索尼尖端的XR硬件与西门子Xcelerator产品组合中的软件相结合,从而以最自然、最直观的方式在3D CAD中进行设计。现场可体验由捷安特自行车公司提供的高性能赛车的沉浸式数字孪生。

ELF-SR2 27英寸空间现实显示器 (SRD),可提供无需佩戴眼镜的3D观看体验。SRD将用于可视化使用XYN生态系统创建的内容。它还支持与Autodesk VRED、Unity、Unreal Engine、Twinmotion、OpenXR、Nvidia Omniverse、Blender等集成,以帮助行业领导者优化工作流程并以3D方式查看项目。

索尼的空间捕捉解决方案XYN Spatial Capture能够利用无反相机和专有算法,从现实世界的物体创建逼真的3DCG资源,也与mocopi动捕系统一同展出。

三星此次在AWE上展示了多款4K Micro OLED屏幕,包括:

亮度超20000nits,RGB光Micro OLED,尺寸为1.3英寸,分辨率为3888*3888px,4200ppi,色域大于99%;

亮度超15000nits,RGB光Micro OLED,尺寸为1.4英寸,分辨率为4600*5328px,5000ppi,最高120Hz,色域大于99%;

亮度超10000nits,RGB光Micro OLED,尺寸为1.3英寸,分辨率3888*3888px,4200ppi,色域100%;

亮度超10000nits,白光Micro OLED,尺寸为1.3英寸,分辨率为3552*3840px,4000ppi,色域96%。

根据资料,白光Micro OLED一般采用白光OLED加RGB滤光片的方式实现。先通过特定的材料和工艺制作出能够发出白光的OLED结构,底部的白光OLED发光后,光线透过顶部的RGB滤光片,利用滤光片对不同波长光的选择性透过特性,将白光分解或调制出红、绿、蓝三原色光,进而组合形成彩色图像。其中,获得高效率和高纯度的白光是该技术的关键。与之相对的RGB光Micro OLED采用RGB三色独立发光法,由三种不同颜色材料并列的RGB子像素复合为彩色像素。通过蒸镀等工艺,将红、绿、蓝三种有机发光材料分别制备在对应的子像素位置上,每个子像素分别独立发出亮度可调的光,经不同灰阶、不同颜色的光混色后呈现出彩色光。

所以相比白光Micro OLED,RBG光由于是三色独立发光,所以其亮度更高,颜色纯度也更好,不过RGB光Micro OLED需要保证三种材料的发光效率和寿命的一致性,所以对工艺要求也更高。

PICO带来PICO 4 Ultra Enterprise头显以及LBE解决方案和两大开发者工具:WebSpatial和SecureMR。

现场设有多个合作伙伴展位,包括VNTANA 、ShapesXR 、Roundtable Learning和IMMOTION,重点展示XR在培训、教育、医疗保健和LBE等各个行业的融合成果。

VNTANA:支持在PICO头显上即时查看任何3D或CAD文件(包括从SOLIDWORKS到Browzwear再到 Blender)。

ShapesXR:空间设计协作平台,可体验PICO 4 Ultra Enterprise头显带来的3D设计能力。

Roundtable Learning:通过沉浸式模拟彻底改变培训模式,现场带来了“PIT Trainer XR”的叉车操作VR培训方案。

IMMOTION:通过高端的VR解决方案提升LBE体验,通过基于动作的VR技术和实景360º电影,并结合动感座椅,带来寓教于乐的动态VR景点游览。

今年4月,创维XR宣布推出其首款全场景AI智能眼镜,这次更是将这款AI Glasses A6带到AWE现场,同步在现场展示的还有一体化MR头显PANCAKE 1和PANCAKE 2。据介绍,在续航方面,AI Glasses A6可实现日常使用续航达24小时,录像模式下连续录制超1小时的全天候使用需求,30分钟快充即可恢复100%电量。

图源:VR陀螺

AI Glasses A6的34.7克超轻机身采用一体化流线型镜架设计,兼容常规眼镜佩戴习惯。其核心搭载SOC+ISP+ADSP超集成架构,在保障高性能运算的同时实现低功耗运行,配合传感器融合算法与动态追踪技术(IMU),确保防抖、降噪及音频处理的稳定性。

而最为核心的多模态AI能力,采用模块化架构,兼容DeepSeek、豆包、通义千问等主流AI模型,并提供云端/本地双模式选择,满足隐私敏感型与高性能需求用户。设备支持蓝牙5.4直连手机、平板等终端,构建跨设备智能生态核心入口。

AI Glasses A6集成物体识别(如文物讲解)、实时翻译(多语种文字转译)、行程规划等功能,结合端云协同与自适应学习模型,提供无感化智能服务。结合1200万像素高清摄像头,支持语音指令快速启动拍摄,满足运动记录、日常抓拍等多场景需求,实现免提交互。据透露AI Glasses A6计划于今年8-9月正式发布。

亿境虚拟现场展示了以“轻量化+全链路AI”解决方案为亮点的SW3035 AI眼镜。据介绍,其39克机身(不含镜片)与6.9毫米镜腿厚度使智能眼镜形态更加轻盈,现场产品接入谷歌Gemini,可配合多模态交互演示,目的是“重新定义AI与眼镜融合范式”。亿境是国内最早一批入局XR领域的企业,其针对AI眼镜眼镜产品目前也组建了完整的软硬件开发团队,包括摄像&音频等各类算法、功耗优化、兼容适配等,其拥有一套完善的开发SDK,可针对客户需求进行模块化定制,据了解,亿境在AI眼镜上现已与多家品牌企业达成合作。

SW3035 AI眼镜延续高通AR1平台技术积累,通过优化底层驱动与传感器调度算法,提升端侧AI任务效率(如离线语音识别响应速度提升40%)和响应延迟,并为ToB客户提供更好的SDK。同时为快速迁移至尺寸更小的AR1+Gen1做好准备。另外,亿境带显示的AR+AI智能眼镜已经在全面规划筹备中,并且将于6月底人工智能大会上展示雏形机。

AWE现场玩出梦想展示了其单眼4K MR头显,其VST延迟低至14毫秒,并支持手部、眼动追踪和空间锚点功能。玩出梦想为街机厅和家庭娱乐中心(FEC)带来了自研MR-LBE解决方案,现场用户可体验“水母水族馆”“恐龙探险”“国际象棋竞技”三个主题的MR交互演示。除此之外,现场还可体验到《半条命:Alyx》等游戏流畅的SteamVR串流体验。

由合作伙伴Story Studio和MixWorld带来的MR内容,正将空间娱乐扩展到大众市场的主题公园和文化场所,未来也将在数字文旅、MRLBE 大空间、MR展览展示等领域积极探索。

软件开发公司Xrai与亮亮视野合作推出听障人群专用AR眼镜 Xrai AR2,眼镜重量 49g,采用Micro-LED+衍射光波导显示,据了解其电池续航可达 8 小时,较该公司上一款产品 AR One 提升了 700%,眼镜配备充电盒、USB-C 快充功能及波束成形麦克风,以实现全天保持电量充足与连接顺畅。

图源:VR陀螺

该眼镜核心功能包括98%+ 准确率的实时字幕;支持 220 + 种语言的双向实时翻译;说话人识别与噪音消除;AI 驱动的对话摘要;支持定制验光处方。据了解这款眼镜现已开启预售,首发特惠价 750 美元(建议零售价 880 美元),预计 8 月底发货。

ATHENA在现场展示了一台与Even Reality G1一模一样的AR眼镜,其主要用于安保领域。ATHENA是一家垂直于安保领域的企业,其产品包括武器检测系统(Weapons Detection System)、访客管理系统(Visitor Management System)、AI 辅助 X 光检测(AI Assisted X-Ray)、AthenaVision AR 警报眼镜(AthenaVision AR Alert Glasses)等。

图源:ATHENA官网

该眼镜与ATHENA的一系列软件系统结合,可实现通过智能眼镜接收金属探测门检测到的实时警报,例如:“检测到物体” 或 “访客绕过安全检查”。通过智能眼镜接收 X 光扫描中检测到物品的实时警报,例如:“检测到枪支” 或 “检测到危险物体”等众多安保场景的应用。

根据公开信息,ATHENA的创始人Lisa Falzone是一位连续创业者,在不到十年的时间里,她创立并拓展了 Revel Systems—— 首个基于 iPad 的收银系统,将其发展到拥有 700 多名全球员工,在五大洲拥有数万安装案例。她引入了荷兰皇家壳牌、澳洲航空、肉桂卷品牌 Cinnabon 和雅诗兰黛等旗舰客户,并主导了与 Intuit、IBM 和苹果的合作。当Lisa组建家庭时,她深知必须采取行动解决日益严重的校园枪击问题,所以创立了 ATHENA,以便让女儿在更安全的世界中成长。

Auki Labs在现场展示了AR、AI和机器人领域的实际解决方案。Auki Labs的去中心化视觉定位系统 (VPS) 可实现精确的空间定位,这对于沉浸式AR应用、机器人导航以及视障人士辅助技术至关重要。核心是英伟达提供的硬件和软件工具套件。

图源:VR陀螺

Mentra是一家AI拍摄眼镜和AR OS公司,其AI拍摄眼镜产品Mentra Live目前已启动预售,价格为219美元,重量44g,支持拍照、直播、AI语音助手等,形态与Ray-Ban Meta相似,有黑色和透明两个版本。

同时,Mentra还为智能眼镜公司提供开源应用商店和操作系统,使用其 AugmentOS 软件开发工具包 (SDK),品牌方可以构建并部署自己的智能眼镜应用程序。

Auki与Menra合作,在展会现场,用户可体验到Mentra智能眼镜带来的新一代空间导航技术。这款超轻眼镜重量不到40克,并可与Auki的去中心化VPS无缝集成,从而实现位置定位。

图源:VR陀螺

在大型展览馆这种连接受限的复杂环境中,Auki Labs在NVIDIA Jetson AGX Orin上运行VPS,利用其强大的边缘推理能力,确保实时视觉处理和精确的空间定位。

光舟此次在AWE上展示多款使用了其光波导的AR眼镜参考设计,包括LHASA系列的LHASA AIR(单光机双目绿色显示),FOV为30°,最大亮度可达2000尼特;运动系列的AR眼镜,FOV为30°,采用MicroLed屏幕;双目3D LEVOLA系列的AR眼镜,FOV为32°,分辨率为854*480。

图源:VR陀螺

在LetinAR的会客室,VR陀螺体验了其最新的AR光学模组。

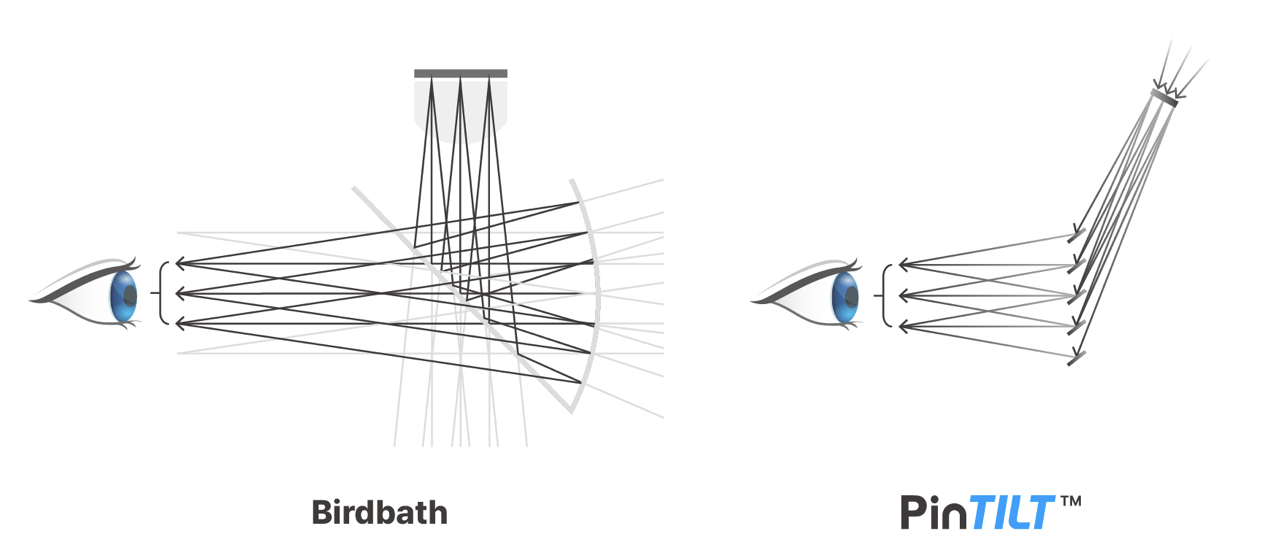

LetinAR是韩国一家老牌的光学企业,成立于2016年,其最早研发针孔成像光学方案PinMR,最新的光学方案采用PinTILT™ 技术,是一种结合了光波导和BB AR光学优点的混合结构。凭借该技术,LetinAR突破了现有AR光学系统的性能限制。去年LetinAR发布了基于PinTILT技术的“FrontiAR™Pro”光学系统,克服了亮度均匀性问题,并进一步改善了图像质量。

图源:VR陀螺

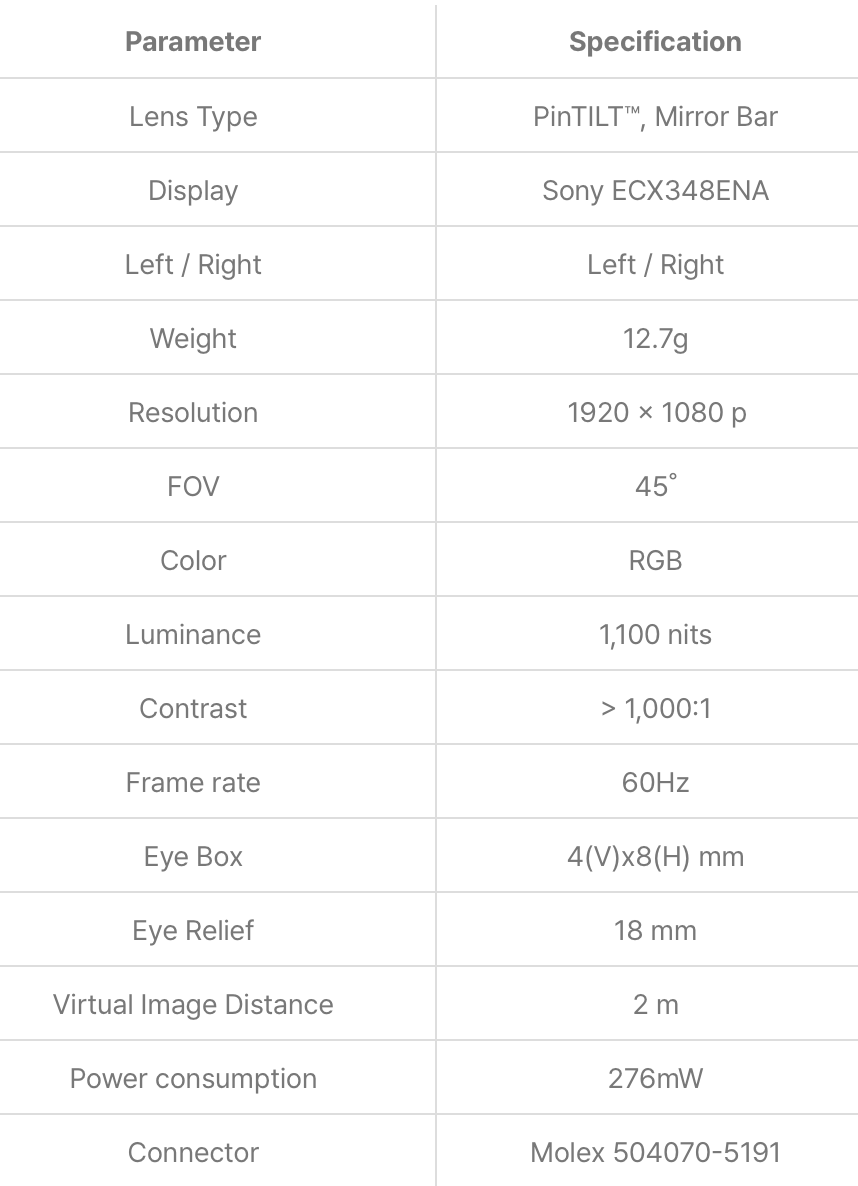

据VR陀螺了解,其目前有三个不同参数的光学模组,Letinus™ Lens模组紧凑轻便,视场角为22度,适用于开发可长时间佩戴的智能眼镜;FrontiAR™模组是Letinus™模块的迭代产品,视场角为45度,适合开发广角智能眼镜;FrontiAR™ Pro Lens模组去掉了针镜,增强了光学均匀性,提供更清晰的视野。

Birdbath与PinTILT光学方案对比(图源:LetinAR官网)

FrontiAR™ Pro Lens光学模组参数,图源:LetinAR官网

LetinAR截止到现在主要的客户来自日本,包括与日本NTT于去年6月推出B端AR眼镜MiRZA XR,以及与TOSHIBA的产品也将在今年不久后上市等。

从整体体验来看,LetinAR的PinTILT光学能够获得比BB更高的透光率,以及更轻的重量,1080P的Micro-OLED屏幕可带来非常不错的显示效果,入眼亮度约500nits。LetinAR透露,其最新的光学产品将于今年8月发布,新产品的重量将更轻,同时目前仍存的由于不同折射区域之间产生的阴影也会在下一代产品中大幅改善。今年,LetinAR计划将其业务拓展至中国。

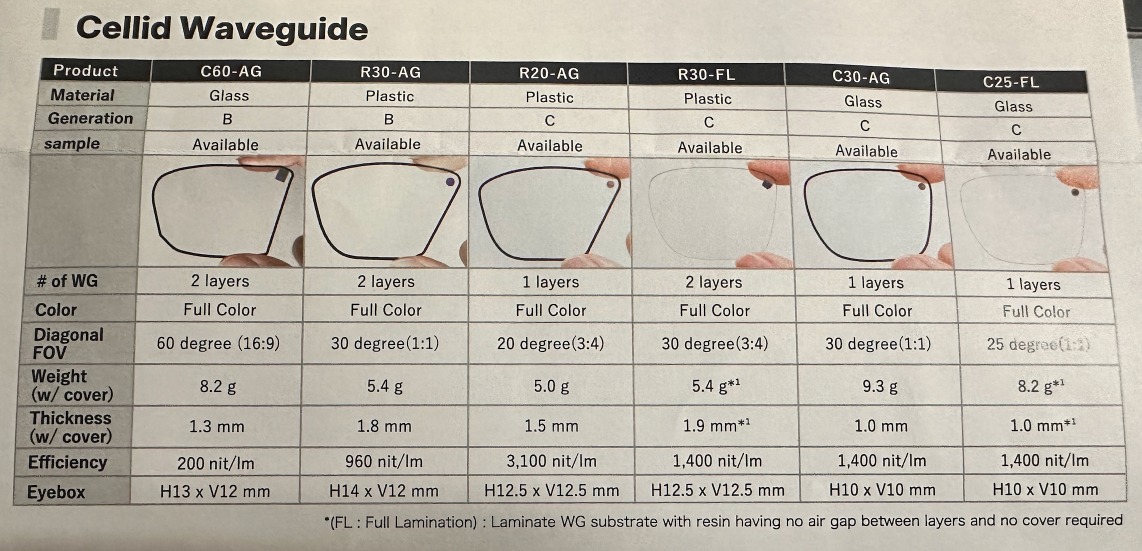

日本初创企业Cellid此次发布了两款实现高亮度的AR光波导产品。同时,该公司还公开了提升AR图像显示质量的软件技术,旨在从硬件和软件两方面推动AR眼镜的普及。

此次Cellid发布的镜片包括塑料光波导R30-FL (C)和玻璃波导C30-AG (C)两种类型。据称与上一代产品相比,分别实现了约2倍和约3倍的亮度提升。这两种镜片均采用薄型轻量化设计,支持全彩显示,即使在明亮环境下也能清晰呈现AR影像。

产品参数,图源:Cellid

同时发布的提升AR影像显示质量的软件校正技术,可通过软件校正因光线干涉等因素导致的色彩不均和失真,解决了以往仅靠硬件难以应对的画质问题。该技术通过高精度测量显示特性,最终对用户所见影像进行优化处理。

该公司计划通过内部开发校正测量技术、提升精度以及优化校正算法,实现能够适应终端个体差异和使用环境变化的“智能校正”。此外,他们还计划推进校正功能的芯片化实时处理、低功耗化以及通过智能手机进行控制等开发工作。

Cellid目前正专注于AR眼镜光学系统的核心技术开发。除镜片外,未来还将推进投影仪的自主研发。同时,为促进实际应用,该公司正与业务公司合作,不仅在核心技术层面,更以最终AR眼镜产品为目标开展验证实验。这种灵活的开发策略正是初创企业特有的优势。

CREAL:可变焦光场显示Clarity Display

CREAL的CEO Tomas Sluka在现场向VR陀螺介绍并展示了其可变焦光场显示屏Clarity Display。

据了解,光场显示的优势在于其可变焦。正常AR眼镜的显示为固定焦面,难以模拟真实的景深效果,据称该光场显示在任何距离下都能实现真正的聚焦,其能够重建现实世界中存在的光线,通过投射具有真实世界景深的数字内容,CREAL 的显示器能够将数字内容无缝融入现实世界。此外,其通过贴膜于镜片上+投影来实现显示效果叠加,所以不仅能够兼容普通屈光眼镜,也能支持带弧度的普通镜片。

图源:VR陀螺

Tomas在现场通过一个可变焦的相机镜头模拟人眼并配合手势识别抓取虚拟物体进行了演示,普通显示方案下无法切换到多个焦面,精准的抓取到虚拟物体,而其演示的光场方案下,可以切换多个焦面,而被抓取的虚拟物体也可以任意改变其位置距离。

VR陀螺从业内专家口中了解到,CREAL的方案为视网膜显示,跟传统显示的区别在于它是一种扫描式的显示,相当于投屏模式。由于它是扫描式,所以其景深比较深,并且有变焦的可能性,或者其焦本身就有比较大的范围,但该方案有诸多受挑战的地方,如光场显示的数据处理、显示质量提升、光学设计以及成本与能耗等。

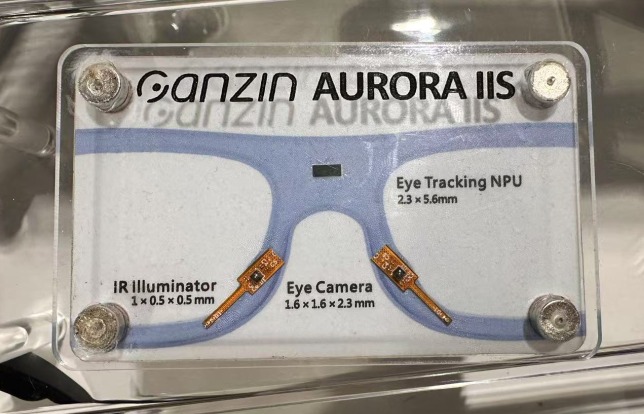

Ganzin是一家眼动追踪技术公司,其在现场展示了其最新的眼动追踪产品Aurora IIS7,这是一款新型 NPU 眼动追踪解决方案,由一个 NPU、两个眼动相机(Eye Sensor)与两个 IR LED 照明组成。NPU 尺寸仅为2.3mm×5.6mm,眼动相机尺寸为 1.6mm×1.6mm×2.3mm,IR LED 尺寸为 1mm×0.5mm×0.5mm,整个模组重量不到 1 克,功耗低于 100mW,可用于VR、AR头显或眼镜上。

据了解该方案无缝集成了奇景光电的 WiseEye™超低功耗 AI 处理器 WiseEye2 和 Ganzin 的专有眼动追踪 AI 算法,凝视采样率为 30Hz,中心视野(FOV)精度为 1 度以下。

Immersix在AWE现场展示了其眼动追踪技术方案的套件,采用视网膜成像技术进行眼动追踪,通过一个结合了光源和摄像头的小型传感器捕捉视网膜的红外图像,再利用算法将视网膜图像转化为眼睛的方向信息,据称不受眼睛位置、形状、颜色、环境光以及设备在头部移动的影响,具有高精度和高稳定性。

该眼动追踪技术解决方案可应用于多种设备,如AR/VR头显、智能眼镜等,能精准追踪用户视线方向和注视点,实现眼控交互、注视点渲染等功能,提升用户体验,还可用于市场研究、用户行为分析等领域,帮助企业了解消费者需求和行为习惯。

PoLight 是一家专注于可调光学技术的挪威公司,成立于 2005 年,其核心产品 TLens 是一种可调光学镜头,旨在复制人眼晶状体的功能,为相机模块市场提供了诸多优势,如极快的对焦时间、极低的功耗、恒定的视野以及极小的尺寸,同时实现高光学质量,能够轻松实现单个和多个相机的应用。

图源:VR陀螺

PoLight 的产品主要服务于需要先进成像解决方案的行业。包括智能手机行业,提供快速对焦等功能;在增强现实领域,为相关设备提供优质成像支持;在可穿戴技术方面,如智能手表、智能眼镜等,帮助提升其拍照或视觉相关功能。据其商务负责人Peter称,其技术核心优势在于能够使产品在即时对焦、低功耗、稳定视野和无磁干扰等,与传统的音圈电机(VCM)镜头相比具有明显的性能优势。结合先进的图像处理技术,PoLight 镜头还能实现如 Instant Focus(瞬间聚焦)、All in Focus(全范围聚焦)和事后全分辨率对焦等新的移动应用功能。

手部追踪和动作捕捉解决方案商UDEXREAL推出了仅重1.6盎司(约45g)的轻薄型VR动捕手套UDCAP。该公司专注于弹性传感器和智能可穿戴设备,支持机器人、模拟和健身领域的高精度动作捕捉。UDCAP采用该公司专有的0.1 毫米弹性传感器,可提供高精度手部追踪,同时保持轻巧灵活的外形。

UDEXREAL表示,该手套提供即插即用设置,无需依赖外部摄像头或照明。它支持物理和虚拟工作流程,连接到PC或VR头显时能够实时检测细微的手指手势。

该手套在设计时充分考虑了跨平台集成,可与Unity、Unreal Engine无缝协作,并兼容主流头戴式显示器、集成追踪系统和空间定位技术。此外,还提供针对工业应用定制的SDK。

现场演示了NeuralDisplay、军事解决方案DayVAS和先进的微型显示器,并展示了可适用于外科手术和军事训练的头显方案。

据称NeuralDisplay眼动追踪软件可以消除许多空间计算系统中用于眼动追踪的专用摄像头的需求,从而减小尺寸、重量、功耗和成本。Neural Display旨在实现动态亮度、对比度和注视控制,监测眼部疲劳,并快速响应神经刺激,例如因“战斗或逃跑”反应引起的瞳孔扩张。

来自中国深圳的一家专注于VR成像的产品解决方案公司Viewpt,在AWE现场展示了Realia VR180 3D相机,可拍摄出高质量VR180和3D SBS内容。

其采用索尼IMX577传感器,拥有170°的宽广视场角,有效像素为3520×3520。可拍摄8K 30fps、6K 50fps和4K 50fps分辨率的视频,支持VR180直播、录制以及3D录制,照片拍摄支持8K VR180照片和4K 3D照片。

据介绍,相机配备3.5英寸、分辨率为800×480的LCD触摸屏,方便即时回放。相机采用航空铝和PC材质,重850g,尺寸为136×74.6×71.89mm,支持多种网络连接、音频接口和存储扩展,续航约1.5小时。售价为1899.95美元。

图源:VR陀螺

Starport在AWE现场展示了一台使用了Lightform技术的投影产品,根据公开信息,Lightform是一种增强现实投影设备,能将数字内容投射到物理表面上。它可扫描环境,精准映射到不规则物体,把电脑中的数字内容通过投影仪投射到现实世界的物体表面,并能根据物体形状和位置实时调整投影效果,让虚拟内容与现实环境融合。其工作原理包含高分辨率摄像头和处理器,通过HDMI电缆连接到投影机。摄像头评估空间中物体的位置和尺寸,处理器根据物体形状生成特殊图案,再由投影机投射出来。

从现场演示可以看到其投影效果几乎完全可以欺骗人眼,被投影的3D Avatar仿佛真的处于空中,而且其中没有幕布或者其他介质。不过从其遮挡关系来看,虚拟物体无法遮挡手,所以其只是从视觉上造成了仿佛处于空中的假象。

图源:VR陀螺

VOY展示了其可用于VR、AR甚至AI眼镜的屈光镜片模组,该模组有两种不同的形态,一种是用于VR头头显如Apple Vision Pro的的磁吸模块,厚度约0.5cm,镜片可支持0-600度调节,镜片呈现薄-厚渐变过渡,通过滑动可以调整度数,售价99美元。原本AVP针对近视人群需要提交验光单后获得相应度数的屈光镜片,虽然能获得很好的体验,但也限定了该镜片只能用户本人使用,其他人无法适配。而VOY的模组则基本能覆盖大部分近视用户的需求。此外,除了近视镜片之外,其还提供-300到+300的远视+近视镜片,售价79美元。

图源:VR陀螺

来自韩国的软件企业正在开发一款面向AR眼镜的导航应用ARNesxT,该应用底层基于谷歌地图,上层UI由公司重新设计,配合AR眼镜使用,将在眼镜上显示如汽车行驶过程中的车速、转向、听歌曲目、来电等信息,现场使用XREAL的AR眼镜进行展示,融合眼镜的Slam,可以实现与现实世界融合的AR导航。

中国VR游戏团队刻世Chaossic在AWE2025上展示了其最新的末世风RPG游戏,核心玩法为手势操控,通过打怪收集掉落的装备不断升级。不同手势对应不同的技能,如击掌可触发冲击波,双手“搓丸子”可以触发火焰球技能,双手握拳拉开则可以召唤闪电,游戏节奏非常快且爽快,同时游戏中还引入了类似钢铁侠中的传送门技能,使用同样的手势就能召唤……目前更多的游戏玩法正在开发中,《泰坦之塔(Tower of Titans)》计划于今年年底上线Meta Quest商店。

图源:VR陀螺

VR游戏开发公司Plai在现场展示了一款与钢琴结合的MR游戏《Piano cafe》,游戏融合了模拟经营和钢琴教学。玩家是一位餐厅后厨的大厨,需要根据客人需求提供餐品。游戏与真实环境融合,虚拟键位将与真实钢琴叠加,以指导用户按相应的键位,而不同的键位对应不同的食材,如面包片、蔬菜、火腿、咖啡都有对应的按键,玩家需要一手操控钢琴来获取食材,同时还需要一手拿餐具接住弹射出来的食材。整体来看,玩法非常新颖且有趣。

图源:VR陀螺

日本公司Logilicity在AWE上首次推出“Anywhere Bungee VR”的VR蹦极项目,结合体感装置,可以体验到仿如真实的蹦极感受。这项沉浸式体验让用户以超逼真的自由落体感从东京都政府大楼等标志性地标虚拟跃下,据称该项目曾在东京塔和阿倍野Harukas等地展出。用户佩戴Quest 3头显并在类似按摩床的软垫上固定好,通过装置的移动和重力的牵引来模拟蹦极的体验,在装置前方放置了风扇,跳下去的瞬间仿佛真的从百米高台一跃而下,体验非常沉浸。

GiiOii成立于 2020 年,是韩国的VR内容工作室,其将故事讲述与艺术、科技和多元文化融合。以往作品包括《Ihyangjeong: Carving with Memories》、《Missing Pictures》和《Find WiiLii》,均曾在西南偏南电影节、戛纳电影节和翠贝卡电影节等重要电影节上展出。

其最新的LBE VR作品《Palace Immersive Goong》将在今年上线,时长为30分钟,在作品中,玩家将作为使者,受邀参加以 VR 形式呈现的朝鲜王朝最后一次宫廷宴会,参与者可以探索隐藏的宫殿空间,并与表演者互动,将韩国历史、传统与沉浸式科技融为一体。该内容将支持韩语、法语、中文和英语。

RP1在AWE上发布了首款元宇宙浏览器,展示了可将用户连接到海量3D内容和第三方实时服务的创新技术。这款浏览器具有很强的可扩展性、实时API集成以及沉浸式互联环境的去中心化托管能力。

VR陀螺在现场体验了该浏览器,整体体验类似VR社交应用,进入虚拟世界后,其工作人员将在虚拟世界中实时引导介绍,通过跳转到不同的虚拟场景,在其中可以浏览网页、参与虚拟活动、与好友社交等,身体动作与面部表情可在Avatar上同步,不过整体画风比较简陋。在虚拟世界中引入了空间音频,声音会根据对方的距离和位置产生变化。

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.png)

.webp)